Artículos

Ciencia de Datos en la Gestión Pública

Por:

Introducción

La discusión de si existe un cambio de época o si vivimos en una época de cambios (De Souza Silva, 1998) parece que hoy está claramente saldada, a pesar de la ambigüedad del término época[1]. Ante nuestros ojos parece mostrarse con cada vez mayor nitidez una nueva etapa histórica, intensiva en conocimiento e información, dada la aparición de algunas aristas distintivas y novedosas. Con la pandemia como catalizador, se observa un nuevo sistema de ideas y de herramientas disponibles cuya centralidad pasa a ser lo digital. Los cambios tecnológicos, económicos y socioculturales, así como las reglas de juego, las formas organizacionales, los modos de relación y los mecanismos institucionales, parecen constituir el nuevo escenario histórico (De Souza Silva et al. 2001).

El proceso de digitalización es en este momento el impulsor más poderoso de la innovación en las organizaciones y en los territorios y continuará así durante las próximas décadas, impulsando a la innovación digital al centro de la próxima ola de cambios protagónicos en nuestras sociedades (Kagierman, 2015). La digitalización significa la creación de nuevas o renovadas redes de personas, procesos y artefactos, incluso a escala global. Las tecnologías que soportan dicha digitalización “avanzan tan rápido que incluso a los expertos les cuesta seguirle la pista, y más aún, entender su impacto global” (Lasry y Kobayashi, 2018: 9). Como afirma Klaus Schwab (2016: 14-15) del Foro Económico Mundial, los cambios en cualquier dimensión de la sociedad son tan profundos que no existió en la historia humana una época con tantas promesas y a la vez peligros.

El surgimiento de las tecnologías digitales como Internet de las cosas (IoT), la inteligencia artificial (IA), la robotización, blockchain y la analítica de Big Data están transformando no sólo los procesos y productos industriales, sino también las organizaciones y actividades de todo tipo, así como la forma en que se articulan y despliegan esas organizaciones en cadenas de valor a escala mundial. Es interesante señalar que la mayoría de las principales tecnologías digitales de la actual revolución en curso (IA, robots, nanotecnología y sensores, impresión 3D) se crearon en la segunda mitad del siglo pasado (Skilton y Hovsepian, 2018: 31). Estos profundos cambios en la forma de diseñar, producir, consumir, decidir e interactuar, sentaron las bases de lo que se conoce como Industria 4.0 ó Cuarta Revolución Industrial[2].

Desde un punto de vista de la gestión de las organizaciones, esta Cuarta Revolución no es sólo un proceso de recopilación de datos a lo largo de todos los procesos involucrados en la producción de bienes o servicios, con diferentes sensores y tecnologías. La recopilación de datos no hace nada por sí misma. Las cuestiones centrales de los nuevos modelos de gestión consisten en cómo crear valor con el análisis de los datos y cómo trabajar articulados en una red con otros actores (internos y externos) necesarios para crear dicho valor (social, económico, ambiental, etc.). Todas las organizaciones de hoy en día tienen la posibilidad de basar sus decisiones y acciones en datos. Hay cada vez mayor conciencia y evidencia del poder de la analítica de datos en nuestra sociedad argentina (Arciénaga et al., 2021). En este sentido, la estrategia de la Industria 4.0 encaja muy bien en toda organización que busque mejorar su inteligencia a partir del análisis de datos digitales y aumentar el valor (social, económico, ambiental y cultural) creado con la analítica de datos y el potencial transformador de Big Data y la inteligencia artificial (Fountaine et al., 2019; Henke et al., 2016: 22-25).

En este contexto, los datos juegan un papel importante en el diseño de las políticas y regulaciones, en las decisiones de los hacedores de políticas públicas y en los instrumentos de gestión. El tratamiento de grandes volúmenes de datos, englobados en el anglicismo “Big Data”, ha abierto la puerta a lo que se ha dado en denominar la gestión por evidencias, complementado con el uso de algoritmos inteligentes que amplían el horizonte de las políticas pública y mejoran los procesos en la gestión pública. A medida que dejamos atrás la era de la pura intuición y entramos en la era de la evidencia, los líderes y decisores políticos necesitan una guía para la toma de decisiones basada en datos.

Por consiguiente, este artículo se sitúa en la intersección entre la ciencia de datos y la gestión en las organizaciones gubernamentales[3]. Metodológicamente, se trata de un abordaje prospectivo, en el que se tratará de mencionar las experiencias actuales en materia de Big Data, analítica de datos, inteligencia artificial y blockchain en las experiencias de gobierno. Sin embargo, dado el carácter incipiente de dichas experiencias, se recurrirá a los análisis prospectivos para las tecnologías mencionadas como forma de construir escenarios futuros posibles y deseables de cambio.

El trabajo se divide en tres apartados. En el primero, se aborda la naturaleza de los datos, de la ciencia de datos y de las exigencias que estas innovaciones implican en término de capacidades y competencias humanas a nivel de organizaciones públicas de gobierno. Dada las dimensiones no sólo tecnológicas y económicas sino también jurídicas y éticas de los datos como insumo central, se recuperarán aquí algunas voces críticas que señalan que la explotación de datos privados sin respeto a los derechos de privacidad es una “amenaza significativa para la naturaleza humana en el siglo XXI como lo fue el capitalismo industrial para el mundo natural en los siglos XIX y XX” (Zuboff, 2019: 1).

En el segundo apartado se describirán los impactos posibles en la gestión gubernamental basada en datos y evidencias. Los impactos organizacionales y también la construcción del poder en las organizaciones son cuestiones de alto valor a ser indagadas. Finalmente, las conclusiones tratarán de sintetizar algunas recomendaciones prácticas para una transición posible a la administración pública basada en evidencias y datos.

Datos y Ciencia de Datos:

Uno de los temas que ha recibido gran atención en los últimos tiempos es el referente a los grandes datos, denominado con el anglicismo Big Data. Si bien apenas se conocía hace unos diez años atrás, hoy es una de las cuestiones más analizadas en las organizaciones y prácticamente con impactos en todos los sectores de una sociedad. En esta sección nos centraremos en analizar qué es Big Data, cuáles son las características centrales de los datos digitales[4], qué abarca la ciencia de datos y por qué estas tres cuestiones son una herramienta importante en los procesos organizacionales. En este último caso, se abordarán brevemente cuáles son los beneficios y desafíos que aporta el análisis de datos y cómo impacta en las organizaciones.

Definición y Descripción de Big Data:

A pesar de su importancia y presencia en las discusiones, no hay consenso sobre cómo definir Big Data. En un primer momento se definieron en función del tamaño de las bases de datos y la imposibilidad de tratarlas con herramientas tradicionales. Pero el concepto de Big Data no sólo hace referencia a los volúmenes de datos a tratar, sino también a la cantidad de transacciones y a la cantidad de fuentes variadas de datos. Estas tres características son tan grandes y complejas que requieren métodos y tecnologías especiales para extraer información de los datos (no posible con un almacenamiento de datos tradicional). En una palabra, las soluciones tradicionales se quedan cortas cuando se trata de Big Data.

Big data se refiere entonces al conjunto de datos digitales y al proceso de recopilación de los diferentes tipos que son colectados por sistemas avanzados en cualquier organización. Originalmente, Big Data incluía datos estructurados, pero ahora también abarca datos no estructurados o semiestructurados del funcionamiento de la organización, de la producción de bienes o servicios, de redes sociales, de flujos de clics y/o videos y/u otras fuentes (textos, imágenes, datos de series temporales, datos financieros, clima, parámetros industriales como la temperatura, entre otros.).

Big data se refiere entonces al conjunto de datos digitales y al proceso de recopilación de los diferentes tipos que son colectados por sistemas avanzados en cualquier organización.

Hoy en día, el término se utiliza también para referirse a cualquier tipo de método de análisis que pueda comprender y extraer valor de datos complejos y hacer un uso de ellos en las acciones y decisiones de las organizaciones (Tomcy y Pankaj, 2017: 20). Para otros autores, Big data se concentra en la colección y el tratamiento de los datos (Mohanty et al, 2015: 3). El énfasis en este caso está puesto en las formas innovadoras y útiles de procesamiento de la información que permiten una mejor comprensión, toma de decisiones y automatización de procesos.

Independientemente de cómo se defina, el fenómeno de Big Data está cada vez más presente en las organizaciones, afectando a sus distintas funciones y con una importancia mayor en relación a sus acciones y decisiones. Existe por lo tanto un enorme potencial para generar valor a través de Big Data: ideas innovadoras, mejor comprensión de los problemas e innumerables oportunidades para predecir, e incluso modelar, el futuro. La ciencia de datos es el medio principal para descubrir y aprovechar ese potencial. Ésta proporciona formas de manejar y beneficiarse de Big Data: ver patrones, descubrir relaciones y dar sentido a imágenes e información asombrosamente variadas.

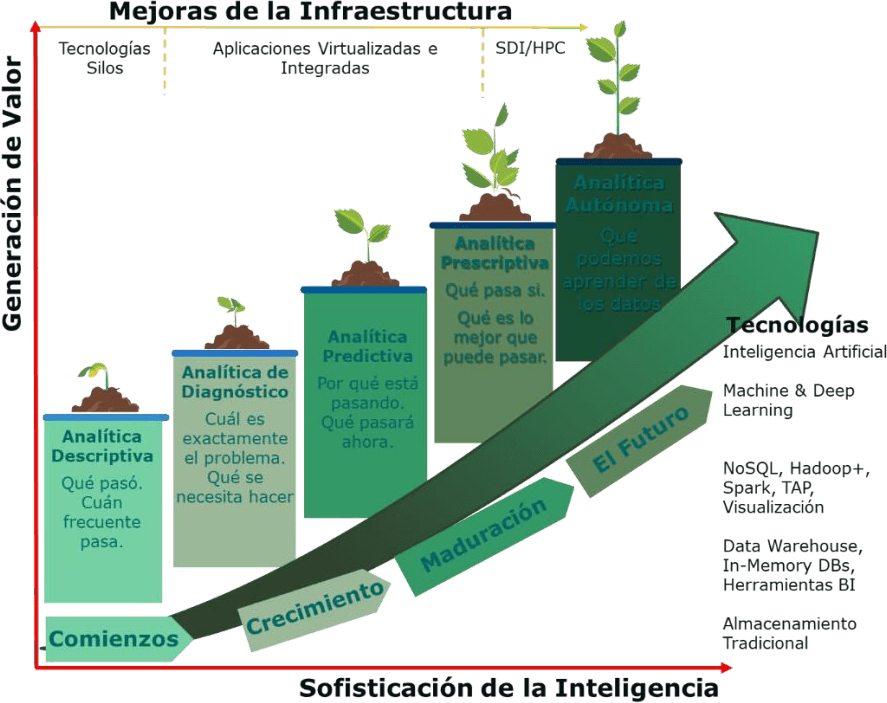

La forma de generar valor a través de Big Data es mediante lo que se conoce como analítica de datos. Ésta es una parte de la ciencia de datos, que ha tenido una evolución constante y hasta dramática en los últimos años. La analítica de datos abarca en la actualidad cinco tipos diferentes:

• Analítica descriptiva.

• Analítica de diagnóstico.

• Analítica predictiva.

• Analítica prescriptiva.

• Analítica cognitiva o autónoma.

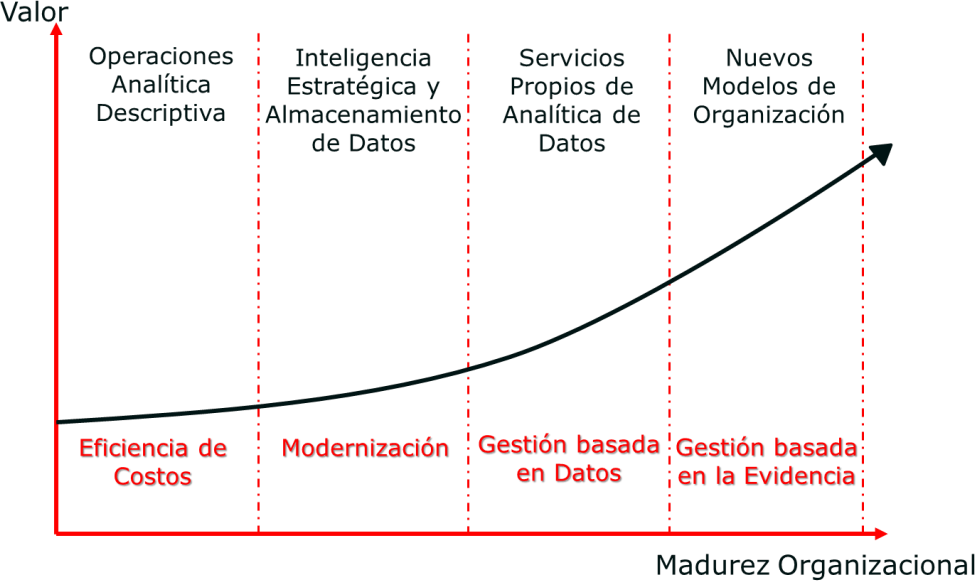

Estas categorías se complementan entre sí de forma escalonada, tal como se muestra en la cadena de valor de la analítica para las organizaciones, en la Figura 1. Cada paso a lo largo de esta cadena mueve a la organización en respuesta a los clientes o usuarios o contribuyentes. La toma de decisiones se vuelve más inteligente y rápida, a la vez que se valoriza con los datos.

Figura 1: Cadena de Valor de la Analítica de Datos basada en Big Data.

Fuente: elaboración propia en base a INTEL (2017: 2) y Attaram y Attaram (2018: 24). Nota: (DBs) es bases de datos; (BI) es inteligencia de negocios; (SDI) es infraestructura definida por software y (HPC) es Informática de alto rendimiento, por sus acrónimos en inglés.

Sobre la base de la Figura 1 es posible distinguir distintos niveles de sofisticación en los distintos tipos de analíticas, pasando de las tradicionales (analítica descriptiva y analítica de diagnóstico) a las categorías más avanzadas. A continuación, describimos brevemente cada una de ellas según la distinción ya realizada por Camm et al., 2020:

• La analítica descriptiva responde preguntas sobre lo que sucedió en el pasado y con cuánta frecuencia.

• La analítica de diagnóstico ofrece información sobre por qué sucedieron las cosas. Mediante el análisis causal trata de entender cuál es exactamente el problema y por qué pasó.

• La analítica predictiva analiza los datos actuales e históricos para proporcionar información de lo que podría suceder en el futuro. Utiliza métodos de minería de datos con el objetivo de hacer pronósticos sobre eventos futuros y hacer propuestas que dependan de estos pronósticos.

• La analítica prescriptiva emplea técnicas de datos como la simulación y el aprendizaje de máquina para sugerir acciones que una organización podría tomar para lograr los resultados que desea. Se implementa utilizando dos enfoques principales, como son la simulación y la optimización.

• La analítica cognitiva, también denominada autónoma, aprovecha las tecnologías de inteligencia artificial (IA), el aprendizaje automático y profundo (deep learning) y el análisis de datos de alto rendimiento para automatizar decisiones. Mediante estas herramientas realiza un análisis similar al humano, mejorando o complementando las decisiones de éste mediante el uso de máquinas y algoritmos inteligentes.

Mediante estas analíticas, el comienzo en la transformación digital de las organizaciones reside en la incorporación de un almacén de datos (data warehousing), una enorme base de datos diseñada específicamente para estudiar patrones en los datos. A diferencia de las bases de datos tradicionales, utilizadas usualmente para las operaciones cotidianas, el almacén de datos permite diversas capacidades de análisis de datos: a) combinar datos de múltiples fuentes para descubrir tantas relaciones como sea posible; b) guardar datos precisos y consistentes; c) estar preparado para permitir una respuesta rápida y precisa a una variedad de consultas; y d) permitir el seguimiento a preguntas específicas relevantes (Albright y Winslow, 2017: 898).

En su gran mayoría, las organizaciones en Argentina, incluidas las gubernamentales, están básicamente entrando a la analítica descriptiva y de diagnóstico (Figura 1), es decir el primer escalón[5]. Muy pocas han avanzado en esta cadena de valor hacia formas superiores de generar valor a partir de los datos y del uso de algoritmos de aprendizaje automático para la toma de decisiones. Entender dónde está situada una organización en esta cadena de valor es importante para tener una perspectiva clara de su situación actual, de sus capacidades y de los cambios necesarios para poder avanzar.

Características de los Datos:

Big Data parece constituir un universo paralelo intangible de datos que rodea a las organizaciones, con una magnitud que se ha incrementado de manera exponencial en los últimos años (Agarwal y Dhar, 2014). El primero en advertir este fenómeno fue Doug Laney (2001), quien no sólo acuñó el término de Big Data sino que también planteó las dificultades en el tratamiento y control de los grandes datos teniendo en cuenta sus características iniciales expresadas como 3 V: volumen, velocidad y variedad de dichos datos. Desde entonces, se han sucedido numerosas nuevas propuestas para caracterizar a Big Data, alcanzándose en la actualidad nuevos modelos como las diecisiete «Vs» (Arockia et al., 2017):

• Volumen: grandes cantidades de datos masivos, desde conjuntos de datos con tamaños de terabytes, petabytes a zettabyte.

• Velocidad: alta tasa de generación y procesamiento de datos de transacciones con alta frecuencia de actualización, lo que implica flujos de datos que llegan a gran velocidad sobre los que hay que actuar en un tiempo muy corto. Esto obliga a no procesar por lotes sino en tiempo real.

• Variedad: los datos provienen de diferentes fuentes (internas y/o externas) y formatos, como datos de transacciones y registros de varias aplicaciones, datos estructurados como tablas de bases de datos, datos semiestructurados como datos XML, datos no estructurados como texto, imágenes, transmisiones de video, declaraciones de audio y más. Hay una tendencia de cambio de datos estructurados únicos a datos cada vez más no estructurados o la combinación de ambos tipos.

• Variabilidad: el significado de los datos cambia constantemente, lo que tiene un gran impacto en los procesos de homogeneización de dichos datos.

• Veracidad: los datos sin procesar generalmente requieren validaciones, lo cual es muy importante para la eliminación de datos falsos (fake news).

• Validez: se refiere a qué tan precisos y correctos son los datos para el uso previsto. Generalmente es necesario limpiar y depurar los datos antes de poder realizar cualquier análisis. La calidad, resultados y valor del análisis de Big Data depende de la calidad de los datos utilizados[6].

• Volatilidad: la antigüedad de los datos puede hacer que éstos sean irrelevantes, históricos o inútiles, por lo cual el tiempo de almacenamiento y la actualización pasan a ser importantes. Antes de Big Data, se tendía a almacenar datos indefinidamente debido a gastos de almacenamiento decrecientes. Sin embargo, debido a la velocidad y el volumen de Big Data, la volatilidad de los datos debe ser considerada cuidadosamente.

• Vulnerabilidad: Big Data trae nuevas preocupaciones de seguridad. Las violaciones a la seguridad de datos alcanzan grandes impactos con Big Data.

• Viralidad: es la capacidad de diseminación que alcanzan los datos. Se define como la tasa a la que los datos se transmiten/difunden por un usuario alcanzando a un gran número de usuarios diferentes para su uso.

• Vocabulario: se refiere a la terminología con la que llegan los datos, como el modelo de datos y las estructuras de datos.

• Vaguedad: es la preocupación por el contenido de realidad en la información contenida en los datos, que puede ser poca o sin ninguna idea a transmitir.

• Viscosidad: se refiera a la diferencia existente entre el evento ocurrido y el evento que está siendo descrito por los datos. Cuanto más viscosos sean los datos, mayor es esta diferencia.

• Verbosidad: se la puede definir como la redundancia de la información disponible en diferentes fuentes.

• Voluntariedad: es referente a la voluntad plena de diversos actores para acceder a grandes datos disponibles, a utilizar según el contexto.

• Versatilidad: es la capacidad de Big Data para ser lo suficientemente flexible como para ser utilizado de manera diferente en contextos diferentes.

• Visualización: es fundamental para mostrar grandes volúmenes de datos complejos mediante el uso de tablas y gráficos, como medios más eficaces para transmitir el significado de hojas de cálculo e informes repletos de números y fórmulas.

• Valor: es el resultado final en el tratamiento de los datos. Es una característica que refiere a las posibilidades de extraer valor con un análisis adecuado de los datos.

A su vez, los datos digitales presentan otras características muy interesantes de destacar. Algunos autores como Brynjolfsson y McElheren (2016) los denominan como el «nuevo petróleo» de la economía digital, aunque las propiedades de dichos datos son bastante diferentes de los recursos fósiles. Estos últimos son perecederos y presentan el principio de exclusión en el consumo. Es decir, desaparecen con el consumo y el que lo consume excluye a otros de hacerlo. Por el contrario, los datos digitales se pueden compartir innumerables veces, sin posibilidad de exclusión y pérdida de calidad o utilidad de los datos originales (Yeung y Lodge, 2019: 10-11).

Algunos autores como Brynjolfsson y McElheren los denominan como el ´nuevo petróleo´ de la economía digital, aunque las propiedades de dichos datos son bastante diferentes de los recursos fósiles.

Desde un punto de vista tecnológico, los datos digitales plantean importantes desafíos técnicos, incluidos formatos de archivos patentados, obsoletos o de baja accesibilidad. También presentan problemas de obsolescencia del hardware, del software y del sistema operativo (Franks, 2021: 226). Se pueden almacenar y transmitir fácilmente, y los algoritmos que utilizan datos digitales son reproducibles. Son también inmunes en gran parte a la distorsión de la señal durante la transmisión electrónica de los mismos. Presentan también mayor portabilidad y durabilidad (en el almacenaje), ya que los datos digitales son más compactos que los datos físicos y salvo condiciones excepcionales no se corrompen.

Ciencia de Datos:

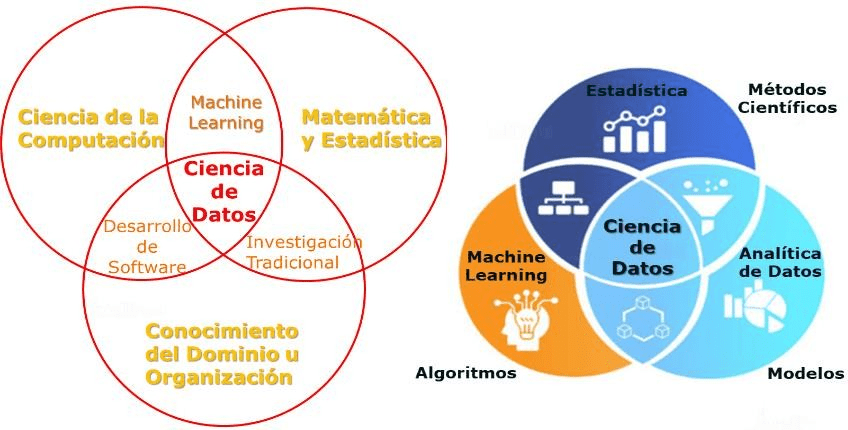

Hoy en día, la ciencia de datos impulsa la toma de decisiones en casi todas las actividades de las sociedades modernas, tanto en organizaciones públicas como privadas, e incluso a niveles personales. El objetivo de la ciencia de datos es mejorar la toma de decisiones basándolas en conocimientos y evidencias extraídos de grandes conjuntos de datos (Big Data). Como campo de actividad, la ciencia de datos engloba un conjunto de principios, definiciones de problemas, algoritmos y procesos para extraer patrones no obvios y útiles de grandes conjuntos de datos Está estrechamente relacionado con los campos de la minería de datos, Big Data y el aprendizaje automático, pero tiene un alcance más amplio.

Autores como Zumel y Mount (2014: XIX) definen a “la ciencia de datos como la gestión de los procesos que pueden transformar hipótesis y datos en predicciones procesables”. Está basada en diversas disciplinas, por lo cual los especialistas suelen venir de otros campos. La ciencia de datos involucra investigadores y profesionales en áreas como estadísticas, reconocimiento de patrones, aprendizaje automático, inteligencia artificial, aprendizaje profundo (Deep Learning), minería de datos, análisis y visualización de datos, entre otros. Hay aproximaciones a la ciencia de datos que enfatizan los problemas y aplicaciones de datos del siglo XXI como base de definición, como por ejemplo el acceso a información de grandes bases de datos, la escritura de código de computadora para manipular datos y la visualización de los datos como sus campos principales (Shah, 2020: 12).

Para el dominio de la ciencia de datos y la analítica de Big Data en las organizaciones, se requieren tres cuestiones mutuamente relacionadas y complementarias: personas calificadas, especialmente con competencias de trabajo en equipos de ciencia de datos, experiencia en la gestión de procesos con un enfoque basado en datos, y herramientas y tecnologías, particularmente herramientas analíticas comprobadas (data mining, machine learning, analítica de datos).

Aunque los términos ciencia de datos, aprendizaje automático (machine learning) y minería de datos (data mining) se usan frecuentemente como sinónimos, en realidad hay importantes diferencias. El común denominador de estos tres términos es que todos tratan de aportar a la toma de decisiones a través del análisis de datos. La ciencia de datos tiene un alcance más amplio. El aprendizaje automático (machine learning) de datos generalmente se ocupa del análisis de datos estructurados, usualmente para aplicaciones comerciales. La ciencia de datos recibe los aportes de estos dos campos, pero los amplía con temáticas como la captura, limpieza y transformación de datos estructurados y no estructurados; el uso de Big Data, de tecnologías para almacenar y procesar grandes conjuntos de datos no estructurados y cuestiones relacionadas con la ética de los datos y la regulación en el uso de los mismos (Kelleher y Tierney, 2018: 1-2).

Por lo tanto, podría decirse que la ciencia de datos es un campo transdisciplinar, que surge de la convergencia de tres grandes ramas de la ciencia y también de la respuesta a grandes problemas aplicados de los datos, como se muestra en la Figura 2:

Figura 2: Ciencia de Datos desde dos Enfoques distintos.

Fuente: elaboración en base a Kelleher y Tierney (2018) y Shah (2020).

Las empresas y los gobiernos suelen utilizar modelos computacionales para manejar grandes cantidades o set de datos, en particular provenientes de tres campos diferentes: minería de datos, redes neuronales artificiales y aprendizaje automático. En el primer caso, la minería de datos, también conocida como descubrimiento de conocimiento en bases de datos, utiliza información existente y análisis de datos para buscar información oculta o patrones emergentes en los datos, para explicar un fenómeno particular. La minería de datos se utiliza con mayor frecuencia para clasificar, secuenciar y describir datos, pero la técnica también se puede utilizar para describir nuevos hallazgos y predecir tendencias futuras. La minería de datos a menudo aparece en modelos de agrupamiento, árboles de decisión y redes neuronales.

la ciencia de datos es un campo transdisciplinar, que surge de la convergencia de tres grandes ramas de la ciencia y también de la respuesta a grandes problemas aplicados de los datos

Los métodos de redes neuronales son diferentes de la minería de datos. Estos modelos están diseñados para imitar el cerebro humano. Al igual que el cerebro se compone de miles de millones de neuronas, los modelos de redes neuronales funcionan para dar sentido a las entradas de datos con el fin de hacer predicciones futuras, reducir la sobrecarga de información o ruido y clasificar eventos. Los programas de redes neuronales hacen esto simulando lo que sucede en el cerebro humano, usando para ello algoritmos de reconocimiento de patrones en los datos y luego extrapolando las conexiones, características y resultados alcanzados para hacer más rápida y precisa la toma de decisiones. La salida de un modelo de red neuronal es similar a lo que sucede en el cerebro cuando usamos heurísticas, que son reglas generalizadas que el cerebro aplica para facilitar la toma de decisiones complejas (Yang, 2015).

En el caso del aprendizaje automático, los modelos de aprendizaje de máquina (machine learning) obtienen conocimiento de los datos existentes y de los patrones existentes en los datos. Este “aprendizaje” entonces proporciona la base para que una máquina o un algoritmo de inteligencia artificial (IA) puedan aprender solos. El aprendizaje automático utiliza algoritmos adaptativos para construir modelos que aclaran las conexiones entre las relaciones, hacen suposiciones de correlaciones entre factores o variables, y aplican lo aprendido para hacer predicciones futuras. A medida que dispone de más datos, la máquina aprende a pronosticar mejor, actualizando luego los algoritmos predictivos. Cuando se usa efectivamente, los algoritmos de aprendizaje automático pueden proporcionar recomendaciones instantáneas y en tiempo real para su uso por tomadores de decisiones, mejorando este proceso.

El uso de la minería de datos, redes neuronales y machine learning como técnicas de aprendizaje no está exento de controversias. Hay preocupaciones éticas obvias cada vez que una empresa o el gobierno recopilan microdatos de los consumidores y ciudadanos. Los decisores políticos y reguladores deben establecer límites entre el derecho a la privacidad de consumidores y ciudadanos, y la recopilación de datos e información para la creación de valor por parte de las empresas o la prestación de servicios públicos.

Big Data, Ciencia de Datos y las Organizaciones Gubernamentales:

Las decisiones en las organizaciones en general, y de los cuerpos gubernamentales en particular, se basan frecuentemente en modas pasajeras y en las historias que se cuentan como casos de éxito. En paralelo, los modelos tradicionales y las nuevas soluciones de vanguardia a menudo no cumplen lo que prometen. Esta situación deja a los decisores políticos y empresariales, consultores y legisladores ante un profundo desafío: ¿cómo mantenerse alejados de las tendencias y soluciones rápidas y, al mismo tiempo, utilizar evidencia válida y confiable para respaldar la toma de decisiones adecuada en una organización?

En respuesta a este problema, se ha gestado desde hace unos 15 años un modelo de gestión basado en evidencias. Este modelo ha evolucionado del tradicional con el objetivo de mejorar la calidad de la toma de decisiones mediante el uso de evidencia, que pueda ser evaluada críticamente a partir de múltiples fuentes: datos organizacionales, experiencia profesional, valores de las partes interesadas y literatura científica (Rousseau, 2006).

En esta evolución de la gestión de las organizaciones y del territorio, mucho tuvo que ver la aparición en forma casi coetánea de Big Data, con la existencia y disponibilidad de grandes bases de datos y el desarrollo del hardware y software como herramientas necesarias para su procesamiento y análisis. La aparición de tecnologías como la computación en la nube generó una alta disponibilidad de datos hasta el punto de brindar casi la ubicuidad (espacial y temporal) de los mismos a distintos actores. En paralelo, la emergencia de la ciencia de datos permitió disponer de herramientas de minería de datos y la predicción de problemáticas, necesidades y comportamientos de clientes, usuarios y ciudadanos, por medio del uso intensivo de técnicas de aprendizaje automatizado. Todo este conjunto de transformaciones ha posibilitado la difusión de modelos de intervención y gestión inteligente en las organizaciones y en el territorio.

Con la gran variedad de fuentes de Big Data, el poder no está sólo en una única fuente de datos. El valor está en la información y significados que pueden extraerse en combinación con otros datos (por ejemplo, un modelo tradicional de pago de impuestos con datos históricos de transacciones puede mejorarse cuando se combina con datos de navegación web de los contribuyentes y otros datos de fuentes de ingreso). Realmente es la combinación lo que cuenta en el caso de Big Data.

Sin embargo, también interviene en la privacidad de los datos de las personas, tanto en una organización como en un territorio. En este sentido, cualquier tecnología no sólo explota o amplía necesidades, sino que también amplía reclamos de derechos (Arthur, 2009). Un ejemplo de esto, es la privacidad de los datos personales, que históricamente estuvo conectada en los últimos 12 años con las discusiones sobre soberanía tecnológica. El vínculo entre estos dos temas tiene que ver con diferentes episodios recientes como el caso de WikiLeaks en 2009, las revelaciones de Snowden en 2013 y el caso de Cambridge Analytica en 2018. Todos estos escándalos revelan el lado oscuro de Internet, el mal uso de los datos personales, la vulneración de la soberanía tecnológica de un país, los abusos de las plataformas comerciales digitales y las prácticas monopólicas de algunas grandes firmas digitales en el uso de Big Data y la analítica de datos. En particular, el caso de Cambridge Analytica[7] ilustra cómo las plataformas digitales dominantes buscan modificar el comportamiento individual de los votantes con análisis de Big Data para cambiar las decisiones democráticas, hecho todo esto de manera sigilosa e ilegal.

Todos estos escándalos revelan el lado oscuro de Internet, el mal uso de los datos personales, la vulneración de la soberanía tecnológica de un país, los abusos de las plataformas comerciales digitales y las prácticas monopólicas de algunas grandes firmas digitales en el uso de Big Data y la analítica de datos.

La disputa por los datos y la falta de respeto por los derechos de privacidad llevaron a la profesora de Harvard, Shoshana Zuboff, a decir que vivimos en los últimos 15 años en la “era del capitalismo de vigilancia”, una nueva fase en la evolución de la economía de mercado que hoy parece convertirse en la forma dominante de capitalismo en nuestro tiempo (Zuboff, 2019: 4- 6)[8]. El modelo de monetización de datos personales es una lógica dominante “al capital privado pero entrega poco valor público, no respetando nuestros derechos fundamentales” (Bria, 2019: 164). Uno de los principales problemas que plantean las TIC es que el uso de estas tecnologías involucra necesariamente en gran medida datos personales como clientes (productores) o como ciudadanos, pero esto es muy diferente a la manipulación del comportamiento (Kramer et al., 2014; Dobrowolska et al., 2021: 87; Rubinstein, 2013).

Por otra parte, el adecuado tratamiento de los datos permite responder a preguntas críticas para una organización, y en particular para la administración pública, como:

• ¿Cuáles son los efectos (esperados e inesperados) de las políticas diseñadas para diferentes grupos objetivos?

• ¿Cuánto costará la implementación de una dada política o regulación?, ¿Cuál es el grado de factibilidad o sustentabilidad de una política o instrumento? ¿Será realmente factible?

• ¿Cuál es la respuesta de los actores involucrados a las políticas desplegadas?

Para responder a estas preguntas ahora hay una gran cantidad de datos disponibles, como redes sociales, sitios de revisión, términos de búsqueda, teléfonos celulares, Internet de las cosas, GIS y drones, cámaras de CCTV, satélites, sensores de tráfico, entre otras.

Gran parte del valor generado por Big Data para las organizaciones se concentra en cuatro resultados primarios (Grable y Lyons, 2018: 18):

• Ayudar a las organizaciones a mejorar su productividad y a reducir costos.

• Ayudar en responder rápidamente a los cambios de su entorno y en la demanda del consumidor, usuario o contribuyente.

• Permitir a los administradores detectar problemas o fallas de sistemas dentro de una estructura organizacional.

• Mejorar la toma de decisiones a nivel tanto estratégico como operativo.

Además de los desafíos de la privacidad de los datos, la incorporación de bases de datos compartidas dentro de las organizaciones también implica importantes desafíos organizacionales, sobre todo los vinculados a la construcción del poder. Las organizaciones silos, en los cuales los datos e información se acumulan en distintos sitios, sin conexión, han sido útiles históricamente a la construcción fragmentada del poder. La centralización y centralidad de los datos para la toma de decisiones impacta de lleno en estas lógicas y prácticas, introduciendo drásticos cambios, tanto en la gestión de recursos y capacidades internas como en la proyección estratégica de una organización. El tratamiento de los datos juega entonces no sólo un papel instrumental (en la eficiencia operacional) sino también es un factor catalizador de cambio profundo en la cultura, los valores y la estrategia organizacional (Dobrowolska et al., 2021: 74).

Por otro lado, las organizaciones también enfrentan otros desafíos tecnológicos y organizacionales, que son altamente significativos, como (Sivarajah et al., 2017: 264):

• Las complejidades de la integración de datos.

• La falta de personal calificado y de recursos informáticos suficientes.

• La seguridad de los datos en conexión con los problemas de privacidad.

• Infraestructura inadecuada de hardware.

• Arquitectura de almacén de datos (data warehouse) insignificante o escasa.

• La sincronización de grandes datos.

Gestión Gubernamental Basada en Datos y Evidencias:

La pandemia ha impactado notablemente en la sociedad, y el gobierno en sus distintos niveles no ha sido la excepción. Podría incluso decirse que el COVID-19 ha significado una especie de intento de golpe de estado silencioso, frente al cual los gobiernos de cualquier signo político tuvieron que dar respuestas rápidas y decisivas. Están ocurriendo en estos momentos cambios gubernamentales importantes, casi drásticos, muchos de los cuales estaban previstos para los próximos cinco e incluso diez años. En forma acelerada observamos cómo se han puesto en marcha acciones para digitalizar la administración pública, automatizar los procesos de los servicios públicos, mejorar la ciber-seguridad de los datos de los ciudadanos, nuevos procesos de trabajo para los empleados públicos, la aparición de plataformas para normativas y procedimientos regulatorios, nuevas formas de apoyo a las necesidades tecnológicas y laborales del sector privado, y nuevos modos de participación y de involucrar a la ciudadanía.

En paralelo, los ciudadanos también han migrado sus hábitos de interrelación, tanto en términos de comunidad como en su relación con el Gobierno y los servicios públicos. Está emergiendo una nueva cultura digital en la que también caben nuevas formas de interacción con el Estado en sus distintos niveles. Todo apunta entonces a señalar que los cambios provocados por la pandemia son de carácter estructural, y que la nueva normalidad será cada vez más digital y virtual (Arciénaga et al., 2021).

Está emergiendo una nueva cultura digital en la que también caben nuevas formas de interacción con el Estado en sus distintos niveles

En este apartado se analizará en primer lugar los impactos de las tecnologías analizadas en el epígrafe anterior en los modos de gestión de las organizaciones gubernamentales, con el advenimiento de lo que se ha dado en llamar la gestión por evidencias. A continuación, se identificarán algunas cuestiones organizacionales que son impactadas por la ciencia de datos, al igual que aspectos éticos que aparecen como desafíos importantes a resolver. Finalmente, se hará una breve reseña de las iniciativas en Argentina.

Gestión por Evidencias:

La gestión de las organizaciones basada en datos y evidencias podría pensarse como la norma en la conducción de cualquier entidad. Sin embargo, la práctica en la administración (tanto pública como privada) suele estar basada en numerosas experiencias y decisiones que no necesariamente tiene como base datos sólidos y evidencia. Nos referimos a conocimientos obsoletos adquiridos en la educación formal, usanzas y prácticas antiguas pero nunca probadas, patrones obtenidos de la experiencia subjetiva, métodos conocidos o en los que tenemos entrenamiento, en las habilidades que se disponen, o en información de proveedores de productos y servicios (Pfeffer y Sutton, 2006).

Por el contrario, la gestión basada en evidencia significa traducir los principios basados en la mejor evidencia en prácticas organizacionales (Rousseau, 2006: 256). Es interesante de destacar que el origen de este modelo de gestión proviene del campo de la medicina (Sackett y Rosenberg, 1995), y de allí a comienzos de este siglo se difundió al campo de las organizaciones en general.

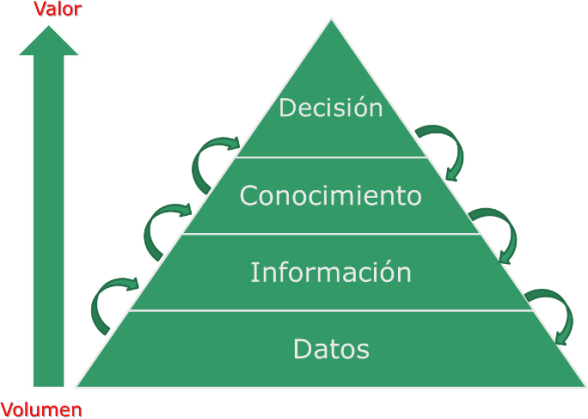

Cobra particular sentido señalar la relación existente en una organización entre datos, información, conocimiento y decisiones, como puede verse en la Figura 3 a continuación. Los datos cuando se estructuran adecuadamente se transforman en información útil y pertinente para la toma de decisiones. A su vez, cuando la información se contrasta, se asocia y se agrupa, gana significados que la transforman en conocimiento. Este último, junto a la información, cuando llegan en tiempo y forma a los decisores claves, alimentan con criterios y bases la toma de decisiones en las organizaciones.

Por lo tanto, se trata de una relación que no es lineal sino más bien retroalimentada, indicada por las flechas a ambos costados de la Figura 3. Cabe destacar que se trata no sólo de conocimiento explícito, es decir codificable, al que se hace referencia, sino también al conocimiento tácito surgido de las distintas formas del aprendizaje por la práctica en las organizaciones (Nonaka y Takeuchi, 1993).

Figura 3: Relación entre Datos y Toma de Decisiones en una Organización.

Fuente: elaboración propia.

No todas las organizaciones disponen de capacidades de su capital humano en materia de análisis de datos a un nivel profundo. Por el contrario, estas capacidades avanzadas no son una mercancía que se compra fácilmente sino por el contrario, exigen esfuerzos de desarrollo a largo plazo. Relativamente pocas organizaciones han comprometido recursos para colectar grandes volúmenes de datos, con el propósito principal de realizar un análisis exploratorio de los mismos. Al aplicar las prácticas y herramientas de la ciencia de datos, Big Data es una valiosa estrategia diferenciadora en la actualidad. Será una competencia básica estándar en un futuro no tan lejano para todas las organizaciones.

Por ejemplo, la gran cantidad de datos administrativos que posee un gobierno se pueden explotar mediante la ciencia de datos y Big Data para identificar poblaciones en riesgo, como base para el diseño de un programa adecuado que brinde servicios ajustados a la problemática a resolver. Por lo tanto, el mayor desafío no es enseñar a los planificadores de políticas cómo aplicar la ciencia de datos a las bases de datos disponibles para un diagnóstico, sino cómo considerar los algoritmos de manera más amplia, para resolver diversos problemas o aprovechar oportunidades, en el contexto de la prestación de servicios públicos.

Cuestiones organizacionales:

El uso masivo de datos, el análisis adecuado de los mismos y el flujo más rápido de información se suelen enfrentar con la resistencia de organizaciones tipo silo, que no sólo son más complejas de coordinar, sino que guardan o custodian los datos como herramienta de construcción de poder. La transformación digital barre con estas asimetrías de información en las organizaciones de todo tipo, lo que redunda en una menor burocracia administrativa y en decisiones rápidas y eficaces. También se neutralizan las consecuencias negativas en decisiones tomadas con retrasos en la información. La estructura del Estado toma entonces una nueva forma y alcance, en particular con los servicios prestados a la ciudadanía y en la gestión del capital humano en los organismos públicos. La transformación digital afecta a las estructuras verticales, cambiándolas por formas de gestión más horizontales, con grupos de trabajo orientados a proyectos. Ciertamente, la transformación digital no elimina ni equilibra las desigualdades y asimetrías existentes entre los estados en materia de equipamiento y capacidades organizacionales. Por el contrario, la pandemia mostró como las mismas se profundizaron en esta etapa de cambio (Arciénaga et al., 2021).

Además, los intereses velados u ocultos de las organizaciones silo, el temor natural a un futuro incierto, los malos entendidos organizacionales y las diferentes evaluaciones de la situación de partida suelen ser también fuentes de resistencias importantes al cambio. En gran medida, la capacitación puede despejar dudas, mostrar beneficios, abrir espacios a la innovación, mostrar que son posibles flujos de trabajo más ágiles, menos cuellos de botella, procesos más eficientes, mejores condiciones en el medioambiente laboral y trabajo más inteligente.

El cambio al que nos referimos está reflejado en la Figura 4, en la cual puede observarse la evolución de una organización merced a la incorporación inteligente y oportuna de herramientas de analítica de datos y Big Data, como motores principales de las transformaciones digitales.

Figura 4: Evolución Organizacional con la Incorporación de Herramientas Avanzadas de Datos

Fuente: Elaboración propia en base a INTEL (2017: 2)

Numerosas organizaciones obtienen los primeros beneficios de los datos con la implementación del almacenamiento adecuado de los mismos. Esta circunstancia llevó a investigar cómo el almacenamiento de datos puede cambiar una organización, cuál es su impacto en la misma y cómo se pueden cuantificar dichos impactos. El almacenamiento de datos, como arquitectura tecnológica, está diseñado para organizar fuentes de datos dispares en un único repositorio de información. Este tipo de almacenamiento permite desarrollar nuevas capacidades de «toma de decisiones inteligentes» al proporcionar a los decisores acceso a datos de tendencias históricas, difíciles de realizar con bases de datos operativas o tradicionales. El almacenamiento avanzado permite no sólo tomar mejores decisiones sino también mejorar la gestión del conocimiento en la administración pública y brindar servicios de gobierno electrónico, incluyendo el acceso público a la información (Haper, 2009: 2427-8).

Es interesante de destacar algunas buenas prácticas identificadas en la gestión del almacenamiento avanzado[9] de datos en EE.UU., basadas en la experiencia tanto de organizaciones gubernamentales como militares. Entre las más destacadas se pueden nombrar (Pang, 2009: 146-156):

• Garantizar la precisión de los datos de origen en el almacén para mantener la confianza del usuario en la información.

• Estandarizar las definiciones de los datos de la organización.

• Ser selectivo sobre qué datos incluir en el almacén.

• Seleccionar cuidadosamente la estrategia de extracción-transformación-carga (ETC).

• Aprovechar el almacén de datos para proporcionar capacidad de auditoría.

• Aprovechar la web y los portales web del almacén de datos para alcanzar usuarios dispersos.

• Hacer que los datos del almacén estén disponibles para todos trabajadores del conocimiento (no sólo para gerentes o altos mandos de la organización).

• Proporcionar datos en un formato legible por hojas de cálculo.

• Restringir o encriptar datos clasificados o sensibles.

• Realizar un análisis durante el proceso de recolección de los datos.

• Aprovechar la familiaridad del usuario con los navegadores para reducir los requisitos de capacitación.

• Usar técnicas de visualización de la información como las de los Sistemas de Información Geográficos (SIG).

• Aprovechar un almacén de datos para brindar soporte en la recuperación de desastres.

• Involucrar a los usuarios en la identificación de requisitos de almacenamiento.

• Utilizar una arquitectura modular para responder a los cambios en el almacén.

Además, en una segunda etapa, la transformación digital requiere no sólo del agregado de algoritmos para establecer bases de diseño de políticas en forma inteligente, sino también de la simulación de las acciones para ver sus resultados y de la aplicación de la ciencia de datos a la prestación misma de los servicios derivados de políticas y planes. En otras palabras, se requiere de la analítica predictiva y de la prescriptiva para mejorar la gestión de gobierno en materia de diseño e implementación de políticas, como se destaca en la Figura 4.

Por otra parte, ya ha sido comentado como la ciencia y la analítica de datos proveen de soluciones que contribuyen al funcionamiento operativo y estratégico en la gestión pública, aportando a la gobernanza democrática en base a datos e información, lo que podría denominarse back office. No obstante, los servicios públicos también tienen una interfaz de interacción entre el gobierno y los ciudadanos, para las que existen soluciones informáticas (front desk) basadas en inteligencia artificial, como son los asistentes virtuales.

Conocidos también como chatbots, estos programas informáticos se entrenan para simular una conversación o consulta con un ciudadano real. Son considerados la experiencia menos riesgosa de implementación de la inteligencia artificial en el ámbito público. Entre los ejemplo de asistentes se pueden destacar a Watson y su versión jurídica Ross (ambos de IBM), EMMA del Servicio de Migraciones de EE.UU, el asistente digital del Servicio Nacional de Salud en Gran Bretaña, el asistente inteligente MAXIMUS que ha mejorado la experiencia de servicio a los ciudadanos en varios gobiernos nacionales, MISSI para asistir a los turistas en Misisipi, CHIP en Los Ángeles, PAIGE en San Francisco (EE.UU.), entre otros (Borfitz, 2019). Como ejemplo local se puede destacar a Boti del Gobierno de la Ciudad de Buenos Aires.

los servicios públicos también tienen una interfaz de interacción entre el gobierno y los ciudadanos, para las que existen soluciones informáticas

Cuando se menciona el almacenamiento avanzado de datos es también importante destacar los problemas de seguridad tanto en el registro y mantenimiento como en la manipulación de los mismos. La información que los gobiernos poseen de las personas, inmuebles, empresas, criminalidad y actividades diversas es compleja de gestionar y usar, por lo que deben protegerse contra accesos no autorizados o manipulación indebida, sin margen de error. Es aquí donde interviene la tecnología “blockchain”[10], que facilita el manejo de la información de forma confiable, mientras se mantienen condiciones de seguridad de esta información (Cheng et al., 2017: 1).

Un desafío clave que presenta la adopción de blockchain en la administración pública es comprender la dinámica de gobernanza que esta tecnología implica para la gestión. Algunos autores como Tan et al. (2022: 1) destacan nueve tipos de decisiones de gobernanza (arquitectura de infraestructura, arquitectura de aplicaciones, interoperabilidad, mecanismo de toma de decisiones, incentivo mecanismo, mecanismo de consenso, organización de la gobernanza, rendición de cuentas de la gobernanza y control de gobernanza), en tres niveles de análisis (niveles micro, meso y macro). El diseño de sistemas basados en blockchain en el sector público debe basarse en el tipo de decisiones u opciones de gobernanza en cada nivel.

El Observatorio Europeo de Blockchain (https://www.eublockchainforum.eu/) registró 229 aplicaciones declaradas a noviembre de 2020. Aunque la tecnología blockchain se está desarrollando rápidamente, los desafíos de implementación aún permanecen. Otra base que también registra casos de implementación de blockchain a nivel de gobiernos, Airtable (https://www.airtable.com/universe/expsQEGKoZO2lExKK/blockchain-in-government-tracker) registra dos casos de aplicaciones en Argentina (Boletín Oficial del Estado y Agencia de Promoción de Inversiones y Comercio), dos para Brasil (Registro de Inmuebles y Ministerio de Planificación y Presupuesto), uno para Chile (Comuna de Maipú), uno para México (Ministerio de Economía – Unidad de Regulación Comercial), uno para Venezuela (Despacho de la Presidencia), y uno para Honduras (Registro de Propiedad Inmueble). Cabe destacar que Airtable es de origen norteamericano y tiene en la actualidad un total de 203 casos de implementación de blockchain a escala mundial.

Otro impacto importante que merece destacarse son las consecuencias que traen sobre el empleo público estas tecnologías y transformaciones. Hay posiciones encontradas entre quienes consideran los impactos en forma extremadamente pesimista, hasta aquellos optimistas tóxicos que no tienen la capacidad crítica para percibir los problemas generados por la modificación de los procesos de trabajo (Dobrowolska et al., 2021: 64). “Las predicciones de que las nuevas tecnologías harán que los trabajadores sean en gran parte o casi totalmente redundantes son tan antiguas como el propio cambio tecnológico” (National Academies of Science, Engineering and Medicine, 2017: 61).

Ciertamente, como lo comentamos al principio, las discusiones del impacto sobre el empleo de Big Data y de la inteligencia artificial (IA) se encuentran en un terreno prospectivo, ya que todavía no hay datos consolidados para hacer afirmaciones respaldadas por la evidencia. Dicho impacto no sólo se da sobre el empleo sino también sobre la naturaleza misma del trabajo, sobre los procesos de trabajo y sobre las calificaciones de los trabajadores (Dobrowolska et al., 2021: 65). Las competencias tecnológicas de éstos deben ir acompañadas del desarrollo de habilidades blandas (Clavert, 2018; Ustundag y Cevikcan, 2018: 129). Una constelación presente de estas capacidades en las organizaciones marcará la diferencia ante los desafíos de la IA, el aprendizaje automático, la realidad aumentada, el análisis de datos, la computación en la nube, entre otros. Sin embargo, la «paradoja» de esta Cuarta Revolución Industrial es que no sólo requiere habilidades «duras» basadas en el dominio de varias tecnologías TIC, sino también numerosas “habilidades blandas” y conocimientos tácitos, sin los cuales ningún sistema avanzado funciona. Por ejemplo, los sistemas informáticos complementarios y la automatización centrada en el ser humano están abriendo nuevos espacios para combinar los «talentos» de la máquina con el conocimiento y la destreza física y mental de las personas en el espacio de trabajo. Esto traerá nuevos roles, competencias y tipos de trabajo en equipos conjuntos de resolución de problemas humano-máquina (National Academies of Science, Engineering and Medicine, 2017: 48-49).

En el caso de la transformación digital de la gestión pública y de sus servicios, basada en Big Data, la analítica de datos, blockchain y la inteligencia artificial, se trata de un proceso que permite resignificar viejos objetivos con nuevas herramientas digitales y de conocimiento. Nos referimos a la optimización de los procesos y sistemas de trabajo, la mejora de calidad de servicios ofrecidos a la ciudadanía, el incremento de las eficiencias operativas y el aumento de la productividad en los servicios del Estado.

Como todo cambio, el proceso de digitalización no está exento de resistencias, barreras y problemas. Las barreras en particular no sólo son internas a las organizaciones gubernamentales, sino que también abarcan a sus comportamientos estratégicos y de gestión de recursos[11]. Entre las principales barreras para la transformación digital está el importante monto inicial de inversiones a realizar, sobre todo en infraestructura, las que sin embargo se justifican acabadamente por los beneficios casi inmediatos que se obtienen de la puesta en marcha del cambio digital. Frente a la escasez de personal calificado, el Estado también debe hacer un esfuerzo de inversión para el desarrollo de empleos intensivos en conocimiento, tanto en la propia administración pública como en los proveedores de bienes y servicios necesarios. En otras palabras, la capacidad de compra del Estado utilizada de una manera adecuada puede dinamizar una estrategia de desarrollo inteligente a nivel local, provincial y nacional.

La segunda barrera es el cambio de las estrategias tradicionales. El Gobierno 4.0 es una mejora organizacional en las estrategias y objetivos digitales, en la introducción de plataformas adecuadas, en el establecimiento de nuevos estándares tecnológicos, en la implementación de cambios legislativos y en la formación de nuevas habilidades digitales. Por otra parte, si el gobierno consigue transformar esta barrera en una oportunidad, aparecen objetivos estratégicos de orden superior que esta transformación, incluyendo especialmente al sistema educativo, puede desempeñar (Stern et al., 2018)[12].

En tercer lugar, los cambios más dramáticos tienen que ver con las modificaciones sustanciales a todos los procesos de la administración pública. En particular, la transformación digital cambia la coordinación en las organizaciones, como por ejemplo los modos de interacción y cooperación horizontal y vertical entre grupos, la que ya no debería ser un problema ni una carga importante de trabajo. Sin embargo, ello afecta a numerosas estructuras de coordinación pre-existentes, las que suelen oponer amplia resistencia al cambio.

Desafíos éticos:

Cuestiones como la precisión, transparencia, rendición de cuentas, equidad, igualdad de trato y derechos a la privacidad y la libertad de expresión, reflejan las vías principales en torno a las cuales los decisores políticos y los investigadores académicos en ciencia de datos pueden estimar las principales implicaciones sociales y éticas de los algoritmos de aprendizaje en el contexto de Big Data y de la inteligencia artificial (Scantamburlo et al, 2019).

Por otra parte, históricamente, la asignación de recursos en un gobierno ha sido impulsada por la desigualdad cuando no se atienden requerimientos de bien común. Es difícil suponer que un nuevo algoritmo, por elegante que sea, cambiará y resolverá estos problemas de equidad. Lo que sí es cierto, es que con el análisis de datos masivos puede observarse la desigualdad a partir de la información de las acciones del gobierno. El dominio técnico de los algoritmos inteligentes puede permitir simular si una modificación a los mismos mejora o empeora situaciones de inequidad y exclusión, por ejemplo. Probablemente, la combinación de normas, valores y criterios éticos en el diseño de algoritmos inteligentes nos conduzca a una «gobernanza algorítmica», en la que los diseñadores y decisores de políticas puedan combinar la ciencia de datos con la equidad, la inclusión, la transparencia o la igualdad[13].

En los últimos 15 años, uno de los movimientos gubernamentales más transformadores ha sido el planteo de los datos abiertos: la publicación de datos administrativos gubernamentales gratuitos y de código abierto en un formato legible de máquina. Esta aproximación a los datos ha ayudado a escalar la innovación de los gobiernos a un ritmo sin precedentes (Ubaldi, 2013; Attard et al., 2015), mediante las iniciativas de datos gubernamentales abiertos[14].

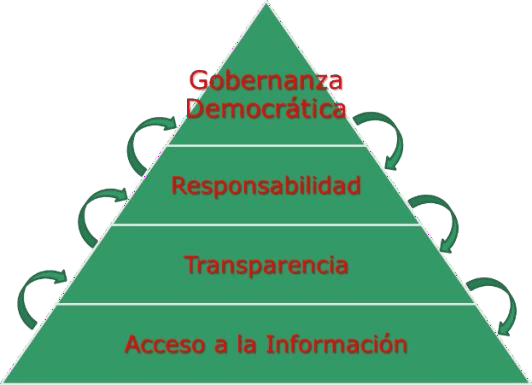

Aunque el objetivo primario de estas iniciativas no fue la transparencia ni la lucha contra la corrupción, lo cierto es que hubo impactos positivos también en estas dos cuestiones. La Figura 5 a continuación muestra los impactos positivos en las acciones de gobierno por parte de las iniciativas de datos abiertos (Attard et al., 2015: 16):

Figura 5: Relación de los Impactos de las Iniciativas Gubernamentales de Datos Abiertos.

Fuente: Attard et al. (2015: 16).

Los datos abiertos dan lugar a una «analítica abierta», es decir a un análisis con datos abiertos cuyo análisis se utiliza de manera responsable para una gobernanza eficaz de la cosa pública, pero a la vez respetuoso del derecho de privacidad de los ciudadanos. Disponer de casos resueltos y de los algoritmos utilizados para ello permite replicar la solución en otras provincias y regiones. En general, todos los gobiernos recopilan datos similares y brindan prestaciones de servicios como la atención a personas sin hogar, la movilidad social ascendente, el tratamiento de la drogadicción, el bienestar infantil, la salud pública, el deporte, el tratamiento de residuos, etc. Proporcionar un código abierto para los algoritmos y datos sería un paso importante en la mejora de las políticas y de las decisiones políticas a nivel de municipios y provincias, movimiento que podemos extenderlo a la Patria Grande.

Entre los desafíos específicos para el uso de la ciencia de datos en el diseño de políticas y la toma de decisiones gubernamentales está la necesidad de combinar conocimiento técnico con un conjunto de condicionantes que no existen en las empresas. En este caso, cuando un nuevo algoritmo aumenta los ingresos, se convierte en el nuevo estándar para la toma de decisiones. En el caso de la gestión pública, hay numerosos intereses económicos, políticos y sociales que deben ser tenidos en cuenta, como la justicia, la equidad, la inclusión y el desarrollo sustentable, además de las condiciones burocráticas de implementación de las acciones y las decisiones. Para que un algoritmo inteligente cree valor en la gestión pública debe desarrollarse tomando en cuenta numerosos requerimientos. A los antes señalados se suelen agregar las condiciones de partida, de cómo se ha prestado tradicionalmente un servicio gubernamental, cuán efectiva fue esa estrategia, si algunos grupos de beneficiarios tuvieron más acceso que a otros, y si hubo transparencia en las decisiones y en la asignación de recursos, por ejemplo.

Proporcionar un código abierto para los algoritmos y datos sería un paso importante en la mejora de las políticas y de las decisiones políticas a nivel de municipios y provincias, movimiento que podemos extenderlo a la Patria Grande.

Finalmente, otra cuestión ética importante es la inclusión digital[15]. Así como hay asimetría en el acceso a la sociedad del conocimiento para las personas, también lo hay para los territorios. Disponer de infraestructura y conectividad en una región son condiciones necesarias para el desarrollo de cualquier solución basada en Big Data, blockchain, inteligencia artificial y la analítica de datos. Cómo incluir digitalmente a todas las personas y regiones de nuestro país es una cuestión de equidad, para la cual se necesitan conjugar cuatro variables críticas: una red nacional de banda ancha, precios de servicios más asequibles, conectividad de acceso confiable y continuo, y un avance en la cobertura a evolución de la Prestación Básica Universal obligatoria para servicios de comunicaciones.

Algunas Experiencias en Argentina:

Existen muy pocos estudios de la implementación de nuevas tecnologías para el tratamiento avanzado de datos en el gobierno argentino, en sus distintos niveles. A nivel nacional destaca la creación en 2017 del Observatorio Nacional de Big Data, cuyos objetivos son los de promover y analizar las implicancias regulatorias y crear plataformas públicas sobre Big Data (SSTIC, 2021: 8). El accionar del Observatorio ha sido algo más que incipiente, a juzgar por las acciones desarrolladas hasta el año 2020.

También podrían señalarse las acciones del Instituto Nacional de Estadística y Censos (INDEC), quien ha incorporado las recomendaciones del Grupo de Trabajo Mundial de Naciones Unidad, del año 2014, para el uso de Big Data en las estadísticas pública. Una de las acciones iniciales fue la firma de un acuerdo de cooperación con el Central Bureau of Statistics (CBS) de los Países Bajos en el año 2017 (Bussi et al., 2017).

Entre las experiencias nacionales de gran alcance cabe mencionar la de integración de bases de datos nacionales, ya en funcionamiento, desarrollada en el marco de la promoción de la ciencia abierta por la ley N° 26.899 de 2013, que regula el desarrollo de repositorios digitales de acceso abierto y promueve la integración de las base de los organismos del Sistema Nacional (SN) de Ciencia, Tecnología e Innovación (CTI) con el objeto de establecer políticas para el acceso público a datos primarios de investigación. Existen en el Sistema Nacional de Bases de Datos y Repositorios Digitales base de datos biológicas, genómicas y del mar, además de repositorios digitales. Esta política se inscribe en el marco del fortalecimiento de las capacidades nacionales de recolección, sistematización, preservación, acceso y utilización de la producción científica nacional producida y financiada total o parcialmente con dinero del Estado (https://www.argentina.gob.ar/redes-de-vinculacion/bases-de-datos).

Otra experiencia para destacar es la del PAMI, a través del programa ITPAMI. En este marco se desarrolla la recolección y análisis de datos para mejorar la atención médica, detectar fraudes de prestadores, reducir costos de tratamientos, digitalizar historias clínicas y mejorar el acceso de los pacientes a sus propios datos, en condiciones de seguridad de los datos. Esta acción ha derivado tanto en mejor atención a los usuarios como en una mayor transparencia en el funcionamiento de la organización. Debido a la envergadura del PAMI, esta política ha tenido un gran impacto en la comunidad de adultos mayores como también en una federalización adecuada de sus políticas dada la gran dispersión geográfica (Malvicino, 2017: 2-3).

Otra cuestión interesante de analizar es el marco legal argentino en este campo:

• Ley N° 25.326 del año 2000, sobre protección de datos personales[16].

• Decreto 1558/2001 – Reglamentación de la ley de protección de datos personales.

• Ley N° 26.899 de Ciencia Abierta.

• Res. Ministerial N°761/14 de sistema nacional de bases de datos de ciencia, tecnología e innovación.

• Decreto 733/18 de “Tramitación digital completa”.

• Ley 25.506 del año 2001, sobre firma digital, y sus modificatorias.

• Ley 27.275 de Derecho de Acceso a la Información Pública.

A nivel operativo, el Estado argentino ha sufrido importantes transformaciones en estos últimos tiempos, con la incorporación de diversas herramientas como:

• Plataforma Digital del Sector Público Nacional.

• Gestión Documental Electrónica (GDE).

• Registro Nacional de Bases De Datos, órgano de control aprobado el 30 de junio de 2003, con arreglo a la directiva 95/46/CE del Parlamento Europeo, para la protección de los datos personales en Argentina.

• Plataforma de Trámites a Distancia (TAD)

• Plataforma de Autenticación Externa (PAEC – AUTENTIC.AR).

• Procedimientos y trámites electrónicos y digitales: expedientes, archivos y notificaciones. Firma digital.

• Publicaciones de las acciones de gobierno en el Boletín Oficial del Estado en la web.

• Gestión de compras y contrataciones digitales (COMPR.AR): principios (simplificación, digitalización, accesibilidad), estándares y procedimientos.

• Sistema de Obra Pública del Estado (CONTRAT.AR).

• Sistema de Subasta Pública Electrónica (SUBAST.AR).

Uno de los pocos estudios en la temática, publicados recientemente en 2021, se realizó a nivel de gobiernos municipales. Se investigó específicamente la apertura de datos gubernamentales en el marco de políticas de Gobiernos Abiertos. Se pueden destacan al respecto los siguientes resultados (Actis et al., 2021: 136-138):

• Se estudió un universo formado por la totalidad de los gobiernos locales de Argentina de más de 50 mil habitantes de acuerdo al último Censo 2010.

• Esto involucró a 122 municipios, con el 63% de la población total del país.

• El 60% de dichos municipios (72) se concentra en 4 provincias (Bs As., Mendoza, Santa Fe y Córdoba).

• El 37% (45 municipios) declaran que implementan algún tipo de iniciativa de “gobierno abierto”, de las cuales 31 entidades (25% del total) se encuentran en la zona centro del país.

• Cinco provincias concentran el 73% de los municipios que implementan iniciativas de gobierno abierto: Buenos Aires (22), Santa Fe (5), Mendoza (3), Córdoba (3) y Jujuy (3).

• 31 municipios (25% del total) poseen iniciativas de datos abiertos, ya sea con portales o mediante la publicación de un conjunto de datos.

• El 77% de municipios con iniciativas de apertura de datos se ubica en la región centro: Buenos Aires (17), Córdoba (3), Entre Ríos (1) y Santa Fe (3).

• Un 98% de los municipios estudiados poseen página web institucional, con sólo 2 municipios sin portales web: Chimbas (San Juan) y Alderetes (Tucumán).

• De los 22 municipios capitales de provincia, 50% declara políticas de gobierno abierto, y 8 de ellos realizan algún tipo de acción relacionada con los datos abiertos.

Entre otras experiencias a destacar, sobre todo a escala provincial, se pueden señalar al Consejo Federal para la Transparencia, cuya finalidad es la cooperación técnica entre las distintas jurisdicciones provinciales y la concertación de políticas en materia de transparencia y acceso a la información pública (https://www.argentina.gob.ar/aaip). El Consejo, de reciente creación, comenzó a funcionar efectivamente en el año 2021.

Como corolario de este recorrido descriptivo se puede señalar que ya existe una importante experiencia en la transformación digital del gobierno argentino en distintos niveles, que el marco normativo aporta un encuadre adecuado para profundizar las transformaciones digitales, aunque resta avanzar de manera importante en la infraestructura y en el software (almacenes de datos, conectividad, desarrollos de software, de algoritmos automáticos específicos, etc.). Es imperativo la disponibilidad de banda ancha como soporte de base (prevista por ARSAT para 2023).

Conclusiones:

La transformación digital de la gestión pública, sobre todo lo atinente a la incorporación de datos masivos y análisis avanzados de los mismos, no es un nuevo software que los funcionarios y empleados públicos tienen que aprender y aplicar, sino que se trata de un conjunto amplio de procesos interrelacionados (políticos, estratégicos, tecnológicos, organizacionales y culturales) que dan forma virtual y digital al modo en que operan y se relacionan los gobiernos: a) en sus distintos niveles entre sí; b) con sus empleados, c) con las empresas y d) los ciudadanos.

Los cambios no son puntualmente algún servicio o la provisión abierta de información, sino que se trata de un frente amplio de transformaciones estratégicas que va desde nuevos procesos de trabajo de los empleados, hasta el difícil rediseño de la estructura organizativa de un gobierno, nuevos tipos de relacionamiento con los ciudadanos, pasando por alguna nueva herramienta de software y nuevos modos de toma de decisiones. Es un cambio sistémico que afecta a todas las funciones de gobierno, al diseño y despliegue de sus políticas, a los procesos de toma de decisiones y a las formas de relacionamiento con la sociedad en general. Cabe destacar que –en gran medida- el principal motor de estos cambios son los nuevos patrones de comportamiento de los ciudadanos, patrones que la pandemia ha acelerado en sus cambios.

La implementación del uso de datos masivos y sus técnicas analíticas para el diseño e implementación de políticas públicas requiere en primer lugar de decisiones estratégicas, luego decisiones de inversión que vayan del almacenamiento avanzado a la implementación gradual de distintos tipos de herramientas analíticas de datos. Se trata de condiciones necesarias aunque no suficientes para avanzar en una gestión pública basada en evidencias, dado que las transformaciones y cambios exigen en primer lugar fuertes decisiones políticas y capacidades organizacionales enfocadas en el logro de nuevos modelos de gestión. También es imperativo contar con un plan para la gestión del cambio en las organizaciones pública y de un fuerte apoyo en la capacitación masiva de los empleados públicos. En este sentido, se necesita no sólo el concurso de los técnicos del gobierno sino también la participación de consultores externos. Para evitar los errores del pasado, los desarrollos no deben ser cerrados, los contratistas deben dejar el código a los gobiernos y deben también estar comprometidos en la puesta en marcha, el mantenimiento y la operación de las soluciones contratadas (Porrúa et al., 2021: 62; Rodríguez et al., 2017).

El enfoque prospectivo adoptado en este trabajo es casi obligado debido a lo incipiente de las experiencias gubernamentales en Argentina, y su escasa documentación. Por ello, se debería recurrir a herramientas de recogida de información en forma más sistemática para avanzar en un diagnóstico de situación y en la documentación de buenas prácticas. Si se pudiera generar un repositorio con experiencias que incluso proporcionen un código abierto para los algoritmos y datos, sería un paso importante.

El valor potencial de la ciencia y analítica de datos, de la inteligencia artificial, y de Big Data no pueden circunscribirse sólo a un simple análisis estadístico. Se requieren de decisiones claras y del concurso de tecnologías complejas, eficientes, escalables y flexibles para rediseñar las organizaciones gubernamentales del siglo XXI.

Bibliografía:

– Actis, Esteban; Berdondini, Mariana y Castro Rojas, Sebastián (2020). Ciencias Sociales y Big Data. Representaciones políticas, disputas comunicacionales y política internacional. Rosario de Santa Fe (Arg.): Universidad Nacional de Rosario Editora.

– Agarwal R. y Dhar V. (2014). Editorial – Big data, data science, and analytics: the opportunity and challenge for IS research. Information Systems Research, vol. 25, nº 3, pp. 443-448.

– Albright, S. Christian y Winston, Wayne L. (2017). Business Analytics: Data Analysis & Decision Making, Sixth Edition. Boston: Cengage Learning Inc.

– Arciénaga, Antonio A., Tuero, Ignacio; Salom, Miguel; Arena, Angélica; Villanueva, Bárbara; Tarcaya, Héctor R.; Rodríguez, Iván y Jakúlica, Ricardo (2021). Acciones de Digitalización Frente a la Pandemia. Actas del Seminario Internacional ALTEC 2021, 26 al 29 de Octubre, Lima.

– Arockia, Panimalar; Varnekha, Shree y Veneshia, Kathrine (2017). The 17 V’s of Big Data. International Research Journal of Engineering and Technology (IRJET), vol. 04, nº 09, Sep, pp. 329-333.

– Arthur, W. Brian (2009). The Nature of Technology. What It Is and How It Evolves. London: Penguin Group.

– Attaran, Mohsen y Attaran, Sharmin (2018). The Rise of Embedded Analytics: Empowering Manufacturing and Service Industry with Big Data. International Journal of Business Intelligence Research, vol. 9, nº 1, pp. 16-37.

– Attard, Judie; Orlandi, Fabrizio; Scerri, Simon y Auer, Sören (2015). A systematic review of open government data initiatives. Government Information Quarterly, vol. 32, nº 4, pp. 399-418.

– Borfitz, Deborah (2019). Digital Assistants Transforming Public Service. AITrends. Disponible en: https://www.aitrends.com/ai-world-government/digital-assistants-transforming-public- service/ Acceso 28/02/2022.

– Bria, Francesca (2019). A New Deal for Data. Incluído como capítulo 13 en McDonnell, John (2019). Economics for the Many. London: Verso Books, pp. 164-173.

– Brynjolfsson, E. y McElheren, K. (2016). The Rapid Adoption of Data-driven Decision Making. American Economic Review, vol. 106, No. 5, pp. 133-139.

– Bussi, Javier; Marí, Gonzalo y Méndez, Fernanda (2017). El Desafío del Big Data en Estadísticas Oficiales en Argentina. Vigesimosegundas Jornadas «Investigaciones en la Facultad» de Ciencias Económicas y Estadística, Universidad Nacional de Rosario, Noviembre. Disponible en: http://rephip.unr.edu.ar/xmlui/bitstream/handle/2133/10331/Bussi,%20Mari,%20Mendez_el%20desafio%20del%20Big%20Data.pdf;jsessionid=6F030B5D8F8E653C980C4E8870B15643?se quence=3 Acceso 03/03/2022

– Calcáneo Monts, Mauricio Augusto (2019). Big Data, Big Data analytics y datos personales en los tiempos del internet: de la autorregulación estadounidense al reglamento general de protección de datos de la Unión Europea. Estudios en Derecho a la Información (UNAM-Mx), Número 8, julio-diciembre. Disponible en https://revistas.juridicas.unam.mx/index.php/derecho-informacion/article/view/13882/15339 Acceso el 10/03/2022.

– Camm, Jeffrey D., Cochran, James J., Fry, Michael J. y Ohlmann, Jeffrey W. (2020). Business Analytics. Boston: Cengage Learning.

– Cheng, Steve; Daub, Matthias; Domeyer, Axel y Lundqvist, Martin (2017). Using Blockchain to Improve Data Management in the Public Sector. Digital Mac Kinsey, febrero. Disponible en: https://www.mckinsey.com/~/media/McKinsey/Business%20Functions/McKinsey%20Digital/O ur%20Insights/Using%20blockchain%20to%20improve%20data%20management%20in%20the%20public%20sector/Using-blockchain-to-improve-data-management-in-the-public-sector.pdf Acceso en 27/02/2022.

– Clavert, María (2019). Industry 4.0. Implications for Higher Education Institutions. State-of- Maturity and Competence Needs. Universities of the Future – Erasmus+ Project. Disponible en: https://universitiesofthefuture.eu/wp-content/uploads/2019/02/State-of- Maturity_Report.pdf Acceso en 12/08/2020.

– De Souza Silva, J. (1999). El Cambio de Época, el Modo Emergente de Generación de Conocimiento y los Papeles Cambiantes de la Investigación y Extensión en la Academia del Siglo XXI. Trabajo presentado en la “I Conferencia Interamericana de Educación Agrícola Superior y Rural”, organizada por el IICA en Panamá, 16-19 de noviembre de 1999.

– De Souza Silva, J.; Cheaz, J.; y Calderón, J. (2001). La Cuestión Institucional: de la vulnerabilidad a la sostenibilidad institucional en el contexto del cambio de época. Serie Innovación para la Sostenibilidad Institucional. San José, Costa Rica: Red ISNAR “Nuevo Paradigma”.

– Dobrowolska, M., Ślazyk, S., Arciénaga Morales, A. A. y Brodny, J. (2021). Research and Analysis of Working Conditions in Industrial Occupations: The Future of Work and Industry 4.0 in the context of Industrial Revolution. Volume 3. Gliwice, Silesia, Poland: Publishing House of the Silesian University of Technology.

– Fountaine, Tim; McCarthy, Brian y Saleh, Tamim (2019). Building the AI-Powered Organization. Harvard Business Review, July–August 2019 Issue.

– Franks, Bill (2012). Taming the Big Data Tidal Wave. Finding Opportunities in Huge Data Streams with Advanced Analytics. Hoboken (NJ): Wiley.

– Franks, Patricia C. (2021). The Handbook of Archival Practice. London: Rowman & Littlefield Publishers.

– Grable, John E. y Lyons, Angela C. (2018). An Introduction to Big Data. Journal of Financial Service Professionals, vol. 72, nº 5, pp. 17-20.

– Haper, Franklin Maxwell (2009). Data Warehousing and the Organization of Governmental Databases. Incluido como capítulo 146 en Wang (2009), pp. 2427-2437.

– Henke, Nicolaus; Bughin, Jacques; Chui, Michael; Manyika, James; Saleh, Tamim; Wiseman, Bill y Sethupathy, Guru (2016). The Age of Analytics: Competing in a Data-Driven World. McKinsey Global Institute. Disponible en: https://www.mckinsey.com/~/media/McKinsey/Industries/Public%20and%20Social%20Sector/Our%20Insights/The%20age%20of%20analytics%20Competing%20in%20a%20data%20driven%20world/MGI-The-Age-of-Analytics-Full-report.pdf Acceso el 05/09/2020.

– Hood, Christopher (2007). Public Management: The Word, the Movement, the Science. Incluido como Sección 1, capítulo 1, en Ferlie, E., Lynn, L y Pollitt, C. (2007). The Oxford Handbook of Public Management. New York: Oxford University Press Inc., pp. 7-26.

– Intel (2017). Guide to Getting Started with Advanced Analytics. Intel Planning Guide. Disponible en https://www.intel.com/content/www/us/en/analytics/getting-started-advanced-analytics- planning-guide.html Acceso el 24/02/2022.

– Kagierman, Henning (2015). Change through Digitization – Value Creation in the Age of Industry 4-0. Chapter 2, pp. 23-32, included in Albach, H., Meffert, H., Pinkwart, A., Reichwald, R. (eds.). Management of Permanent Change – New Challenges and Opportunities for Change Management. Wiesbaden: Springer Fachmedien.

– Kelleher, John D. y Tierney, Brendan (2018). Data Science. Cambridge (MA): The MIT Press.

– Kramer, Adam D.I.; Guillory, Jamie E., and Hancock, Jeffrey T. (2014). Experimental evidence of massive-scale emotional contagion through social networks. Proceedings of the National Academy of Science of the United States of America (PNAS 111), pp. 8788-8790.

– Laney, Doug (2001). 3D Data Management: Controlling Data Volume, Velocity and Variety. META Group Research Note, February 6. Disponible en: Acceso en 02/03/2016.

– Lasry, Brigitte y Kobayashi, Hael (2018). Human Decisions Thoughts on AI. Paris: United Nations Educational, Scientific and Cultural Organization.

– Malvicino, Facundo (2017). Big Data aplicada al sector Salud en Argentina. Definiendo una agenda de trabajo. Buenos Aires: Diálogos Abiertos para el Desarrollo. Publicaciones del CIECTI. Disponible en: http://www.ciecti.org.ar/wp-content/uploads/2017/02/Big-data-aplicada-a-la- salud-.pdf Acceso el 12/03/2022.

– Mohanty, H., Bhuyan, P. y Chenthati, D. (2015). Big Data: A Primer. New Delhi: Springer India.

– National Academies of Science, Engineering and Medicine (2017). Information Technology and the U.S. Workforce: Where Are We and Where Do We Go from Here? Washington, DC: The National Academies Press. Disponible en: https://www.nap.edu/catalog/24649/information- technology-and-the-us-workforce-where-are-we-and Acceso en 14/08/2020.

– Nonaka, Ikujiro y Takeuchi, Hirokata (2014). La Organización Creadora del Conocimiento. Madrid: Oxford University Press España. Publicado originalmente en inglés en 1996.

– Pang, Les (2009). Best Practices in Data Warehousing. Incluido como capítulo 15 en Wang (2009), pp. 146-152.

– Parsons, Cheryl y Hick, Steven F. (2008). Moving from the Digital Divide to Digital Inclusion. Currents: Scholarship in the Human Services, vol. 7, nº 2, pp. 1-16.

– Pfeffer, Jeffrey y Sutton, Robert I. (2006). Evidence-Based Management. Harvard Business Review, enero.

– Porrúa, Miguel; Lafuente, Mariano; Mosqueira, Edgardo; Roseth, Benjamin y Reyes, Ángela María (2021). Transformación digital y empleo público: el futuro del trabajo del Gobierno. Washington: BID.